本地部署deepseek环境

DeepSeek官网地址 https://www.deepseek.com/ .

本文记录在本地部署deepseek环境,主要分以下几个步骤:

- 安装Ollama。

- 在 Ollama 上下载大模型文件。

- 下载安装可视化图文交互界面 Chatbox。

1. 环境说明

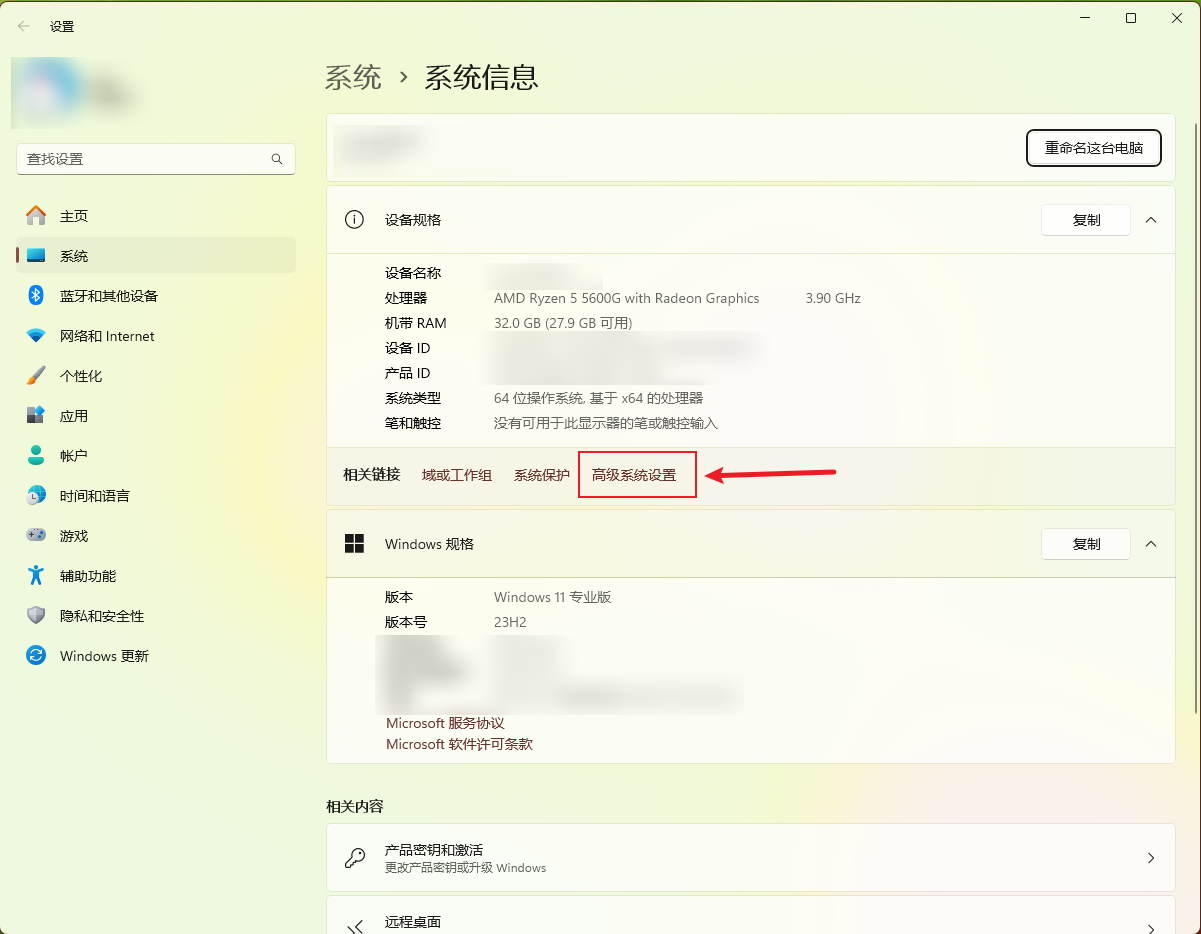

我使用的个人电脑信息说明:

- 版本 Windows 11 专业版

- 版本号 23H2

- 安装日期 2023/8/29

- 操作系统版本 22631.4751

- 处理器 AMD Ryzen 5 5600G with Radeon Graphics 3.90 GHz

- 机带 RAM 32.0 GB (27.9 GB 可用)

- 系统类型 64 位操作系统, 基于 x64 的处理器

2. 安装和配置Ollama

- Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如Llama 3、Phi 3、Mistral、Gemma、deepseek等等开源的大型语言模型。

- Ollama 官网地址 https://ollama.com/。安装包下载地址 https://ollama.com/download。官方提供了MacOS、Linux和Windows操作系统的安装包,你可以根据自己的操作系统下载相应的安装包。

- Ollama官网支持的大模型列表 https://ollama.com/search。

这里https://www.llamafactory.cn/ollama-docs/windows.html是一篇关于Ollama的介绍:

Ollama Windows

欢迎使用 Ollama for Windows。

不再需要 WSL!

Ollama 现在作为原生 Windows 应用程序运行,支持 NVIDIA 和 AMD Radeon GPU。 安装 Ollama for Windows 后,Ollama 将在后台运行,

ollama命令行工具将在cmd、powershell或你最喜欢的终端应用程序中可用。和往常一样,Ollama API 将在http://localhost:11434上提供服务。系统要求

- Windows 10 22H2 或更新版本,家庭版或专业版

- 如果你有 NVIDIA 显卡,需要安装 452.39 或更新版本的驱动程序

- 如果你有 Radeon 显卡,需要安装 AMD Radeon 驱动程序 https://www.amd.com/en/support

Ollama 使用 Unicode 字符来显示进度,这在 Windows 10 的一些旧终端字体中可能会显示为未知方块。如果你看到这种情况,尝试更改终端字体设置。

文件系统要求

Ollama 安装不需要管理员权限,默认安装在你的用户目录中。你需要至少 4GB 的空间来安装二进制文件。安装 Ollama 后,你还需要额外的空间来存储大型语言模型,这些模型的大小可能从几十 GB 到几百 GB 不等。如果你的用户目录没有足够的空间,你可以更改二进制文件的安装位置和模型的存储位置。

- 更改安装位置

要将 Ollama 应用程序安装在不同于用户目录的位置,请使用以下标志启动安装程序:

powershellOllamaSetup.exe /DIR="d:\some\location"

- 更改模型存储位置

要更改 Ollama 存储下载模型的位置,而不是使用你的主目录,可以在你的用户账户中设置环境变量

OLLAMA_MODELS。

- 启动设置(Windows 11)或控制面板(Windows 10)应用程序,并搜索 环境变量。

- 点击 编辑账户环境变量。

- 编辑或创建一个新的用户账户变量

OLLAMA_MODELS,设置为你希望存储模型的路径。- 点击确定/应用以保存。

如果 Ollama 已经在运行,请退出系统托盘中的应用程序,然后从开始菜单或在保存环境变量后启动的新终端中重新启动它。

API 访问

以下是一个从

powershell访问 API 的快速示例:powershell(Invoke-WebRequest -method POST -Body '{"model":"llama3.2", "prompt":"Why is the sky blue?", "stream": false}' -uri http://localhost:11434/api/generate ).Content | ConvertFrom-json故障排除

Ollama 在 Windows 上将文件存储在几个不同的位置。你可以在资源管理器窗口中通过按下

+R并输入以下内容来查看:

explorer %LOCALAPPDATA%\Ollama包含日志和下载的更新

- app.log 包含 GUI 应用程序的最新日志

- server.log 包含服务器的最新日志

- upgrade.log 包含升级的日志输出

explorer %LOCALAPPDATA%\Programs\Ollama包含二进制文件(安装程序会将其添加到你的用户 PATH 中)explorer %HOMEPATH%\.ollama包含模型和配置explorer %TEMP%包含临时可执行文件,位于一个或多个ollama*目录中卸载

Ollama Windows 安装程序注册了一个卸载应用程序。在 Windows 设置中的

添加或删除程序下,你可以卸载 Ollama。如果你已经更改了 OLLAMA_MODELS 位置,安装程序不会移除你下载的模型独立 CLI

在 Windows 上安装 Ollama 最简单的方法是使用

OllamaSetup.exe安装程序。它会在你的账户中安装,无需管理员权限。我们定期更新 Ollama 以支持最新的模型,这个安装程序将帮助你保持更新。如果你希望将 Ollama 作为服务安装或集成,可以使用独立的

ollama-windows-amd64.zip压缩文件,其中仅包含 Ollama CLI 和 Nvidia 及 AMD 的 GPU 库依赖项。这允许你将 Ollama 嵌入现有应用程序中,或通过ollama serve等工具将其作为系统服务运行,例如使用 NSSM。

我这里以Windows 11操作系统部署Ollama 为例说明。

2.1 环境变量设置

Ollama默认会安装在C盘,并将大模型文件也下载到C盘。正常情况下,我们尽量不要将软件包和大文件放在C盘。由于后面需要下载大模型文件,大模型文件占用磁盘空间大,因此需要提前设置一些环境变量。

参考 Ollama环境变量设置

Ollama环境变量说明:

- OLLAMA_HOST:这个变量定义了Ollama监听的网络接口。通过设置OLLAMA_HOST=0.0.0.0,我们可以让Ollama监听所有可用的网络接口,从而允许外部网络访问。

- OLLAMA_MODELS:这个变量指定了模型镜像的存储路径。通过设置OLLAMA_MODELS=F:\OllamaCache,我们可以将模型镜像存储在E盘,避免C盘空间不足的问题。

- OLLAMA_KEEP_ALIVE:这个变量控制模型在内存中的存活时间。设置OLLAMA_KEEP_ALIVE=24h可以让模型在内存中保持24小时,提高访问速度。

- OLLAMA_PORT:这个变量允许我们更改Ollama的默认端口。例如,设置OLLAMA_PORT=8080可以将服务端口从默认的11434更改为8080。

- OLLAMA_NUM_PARALLEL:这个变量决定了Ollama可以同时处理的用户请求数量。设置OLLAMA_NUM_PARALLEL=4可以让Ollama同时处理两个并发请求。

- OLLAMA_MAX_LOADED_MODELS:这个变量限制了Ollama可以同时加载的模型数量。设置OLLAMA_MAX_LOADED_MODELS=4可以确保系统资源得到合理分配。

- OLLAMA_ORIGINS: 允许的源列表,星号*或使用逗号分隔。

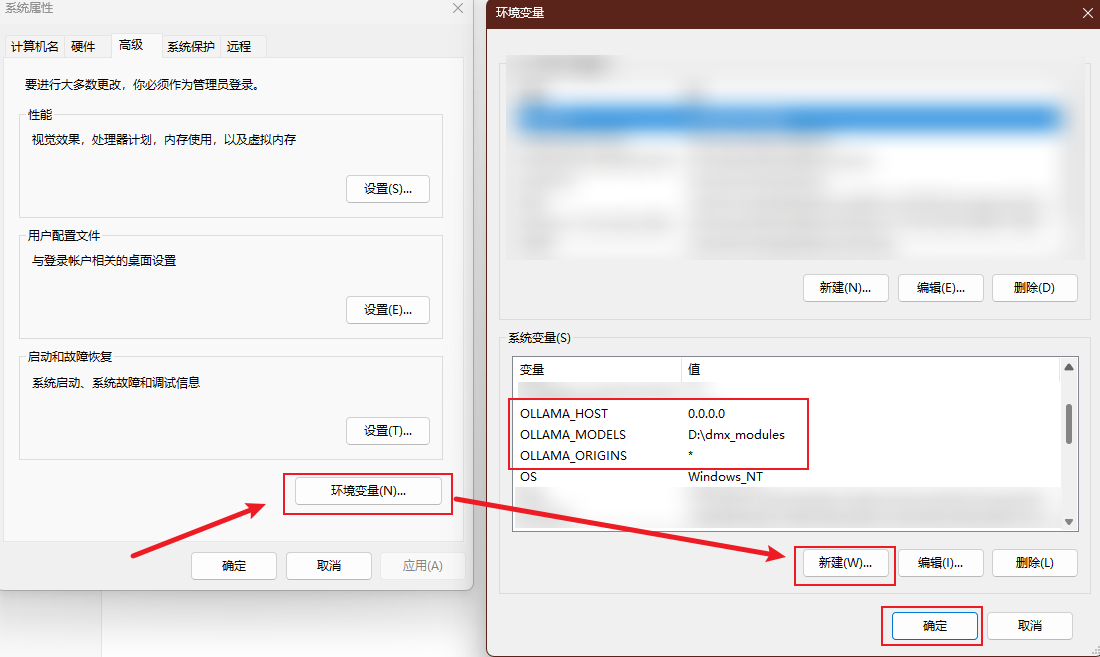

我们主要设置以下三个环境变量:

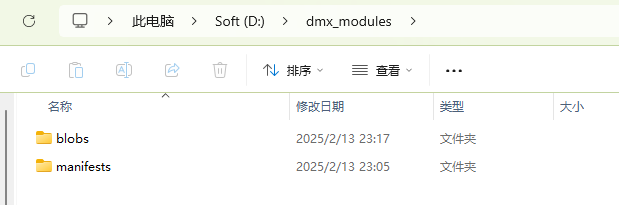

- OLLAMA_MODELS = D:\dmx_modules

- OLLAMA_HOST = 0.0.0.0

- OLLAMA_ORIGINS = *

windows 11可以依次点击【此电脑】右键---选择【属性】---【高级系统设置】:

在弹出的窗口点击【环境变量】,然后点击【新建】:

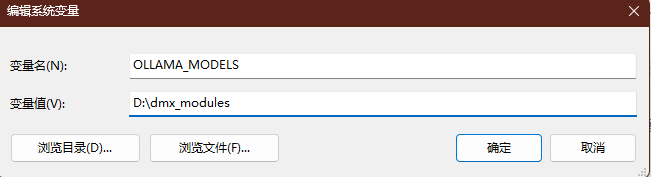

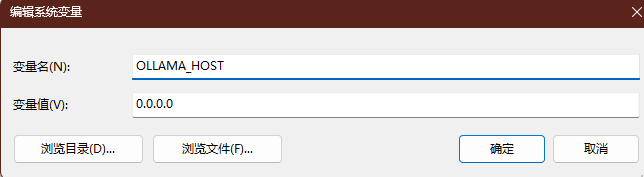

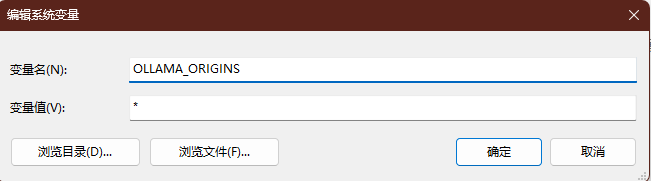

像我这样配置三个环境变量即可:

OLLAMA_MODELS 环境变量:

OLLAMA_HOST 环境变量:

OLLAMA_ORIGINS 环境变量:

配置完成后,依次点击几个【确定】按钮,关闭环境变量配置窗口即可。

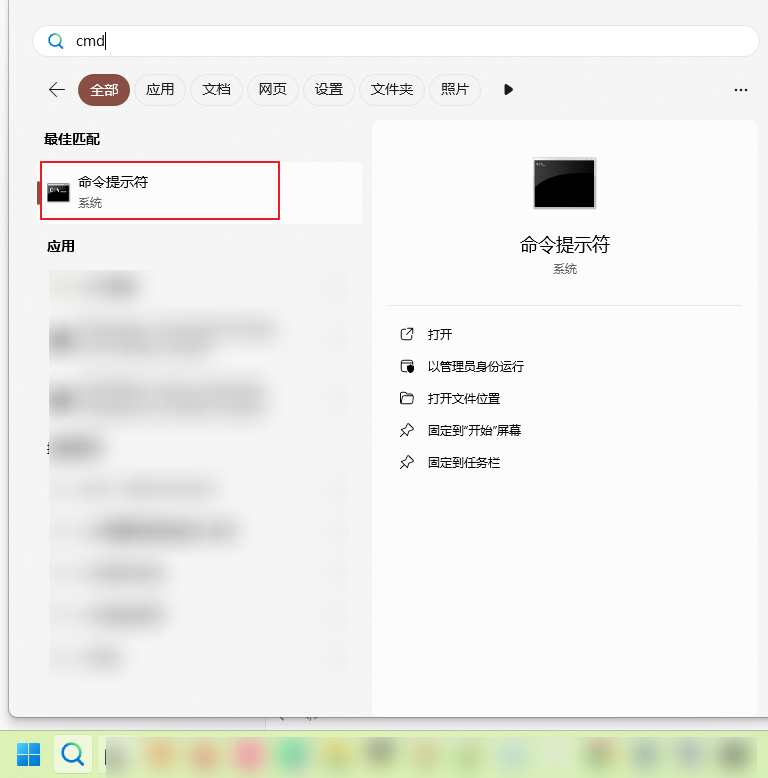

打开命令提示符窗口:

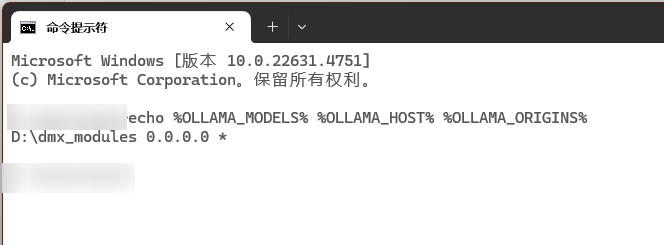

然后在命令行输入:

echo %OLLAMA_MODELS% %OLLAMA_HOST% %OLLAMA_ORIGINS%如果输出和我一样则说明配置的环境变量生效了:

提示

注意,在D盘根目录下创建目录 dmx_modules ,用于存放后面下载的大模型文件!!!

2.2 Ollama安装

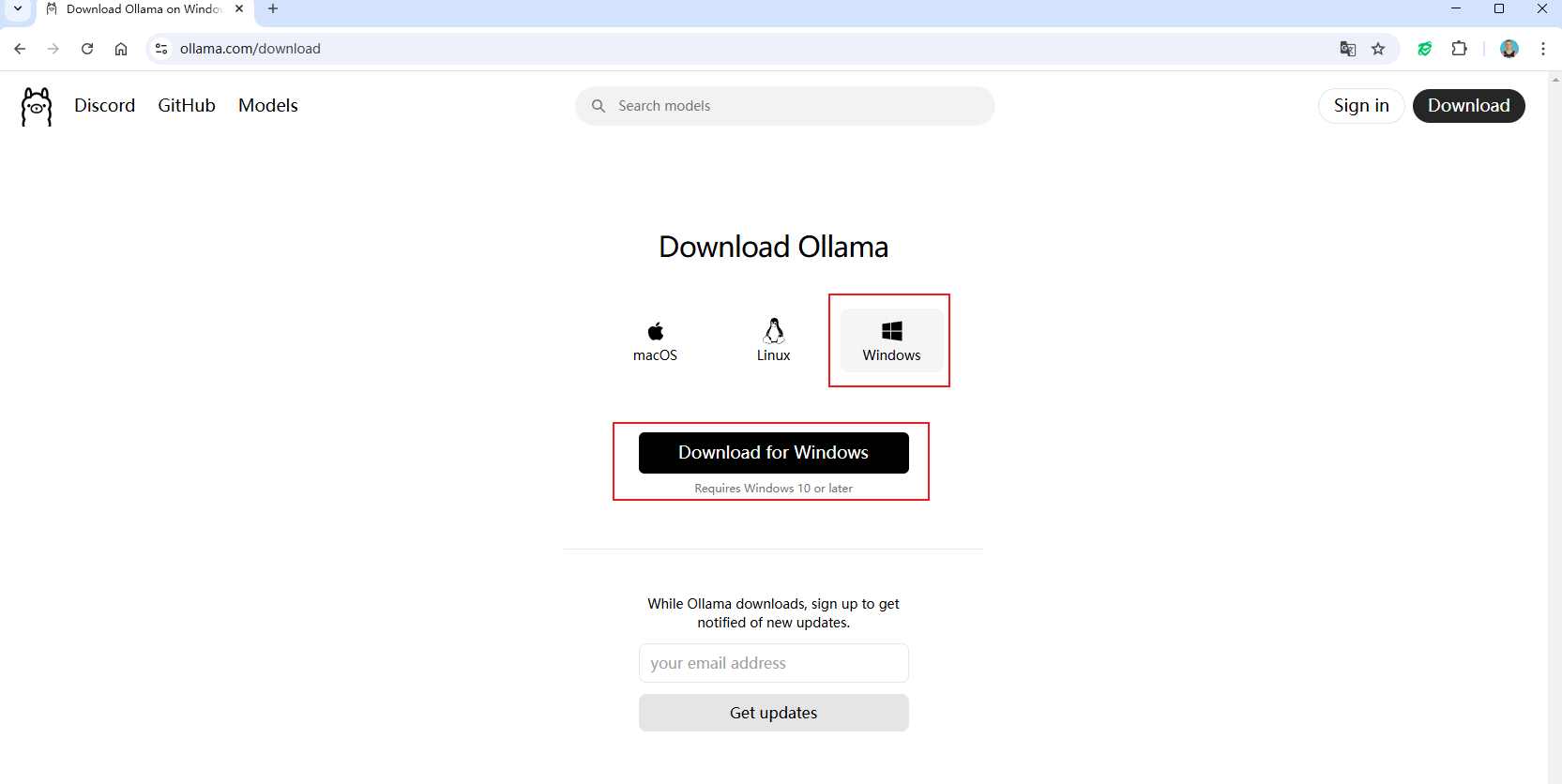

可以访问 https://ollama.com/ 进入 Ollama 官网下载 Ollama ,下载时有三个系统的安装包可选择,这里只需要选择下载我们电脑对应的操作系统版本即可,这里我选择的是 Windows 版本。

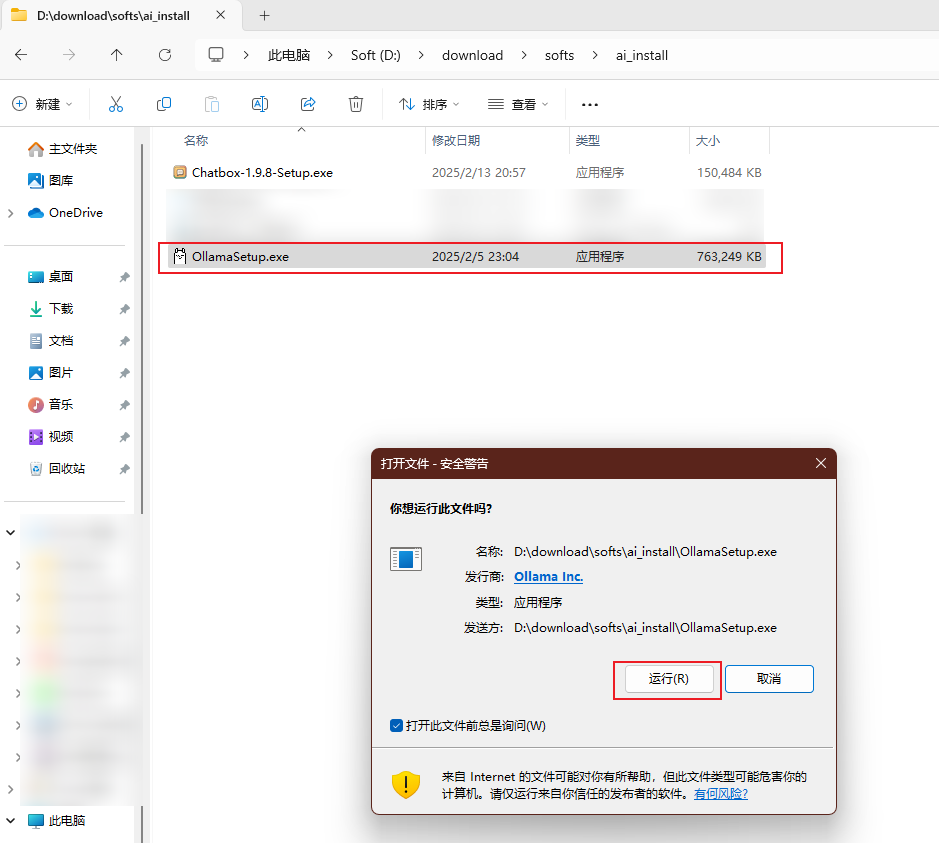

下载好安装包后,双击OllamaSetup.exe,然后点击【运行】安装即可:

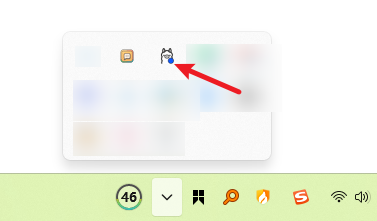

安装完成后,选择开机启动,Ollama就会默认在后台启动,并在电脑右下角可以看到Ollama的图标:

你也可以看看B站Up主录制的视频本地部署大模型Deepseek,更改Ollama模型储存位置,1.5B——14B样机演示

2.3 检查Ollama命令行是否能正常工作

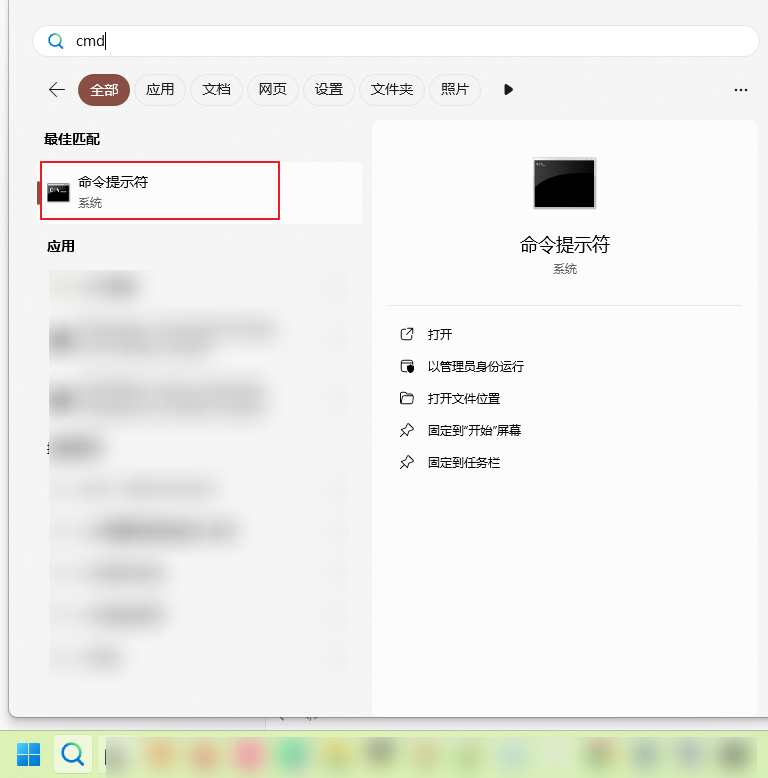

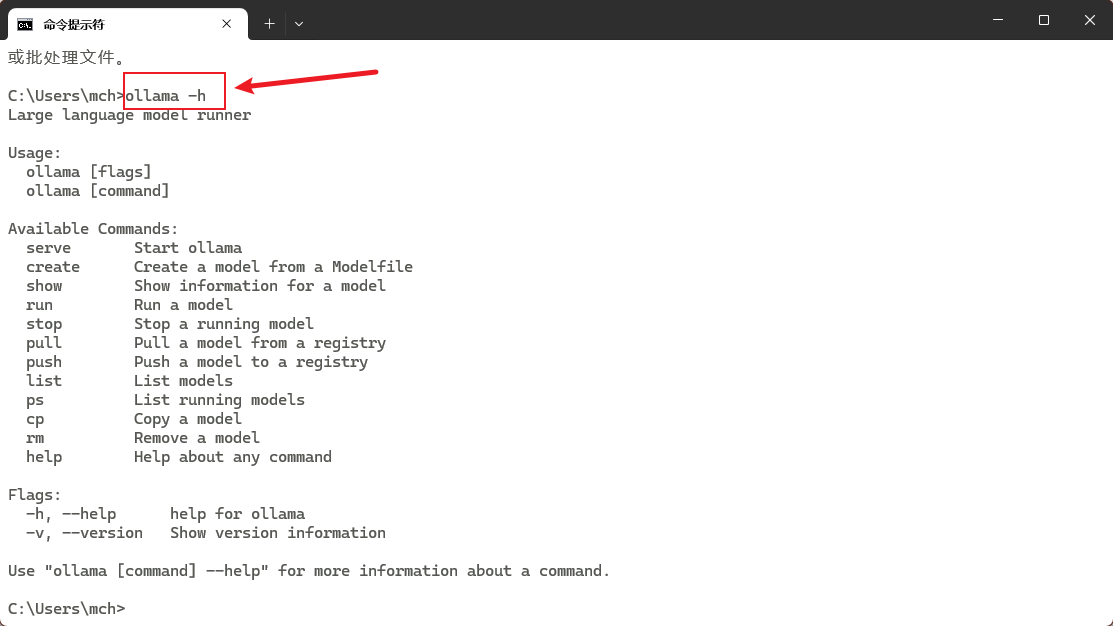

打开命令提示符窗口:

然后在命令行输入:

ollama -h如果有以下输出则说明Ollama命令行能够正常工作!

C:\Users\mch>ollama -h

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

C:\Users\mch>

3. 下载大模型文件

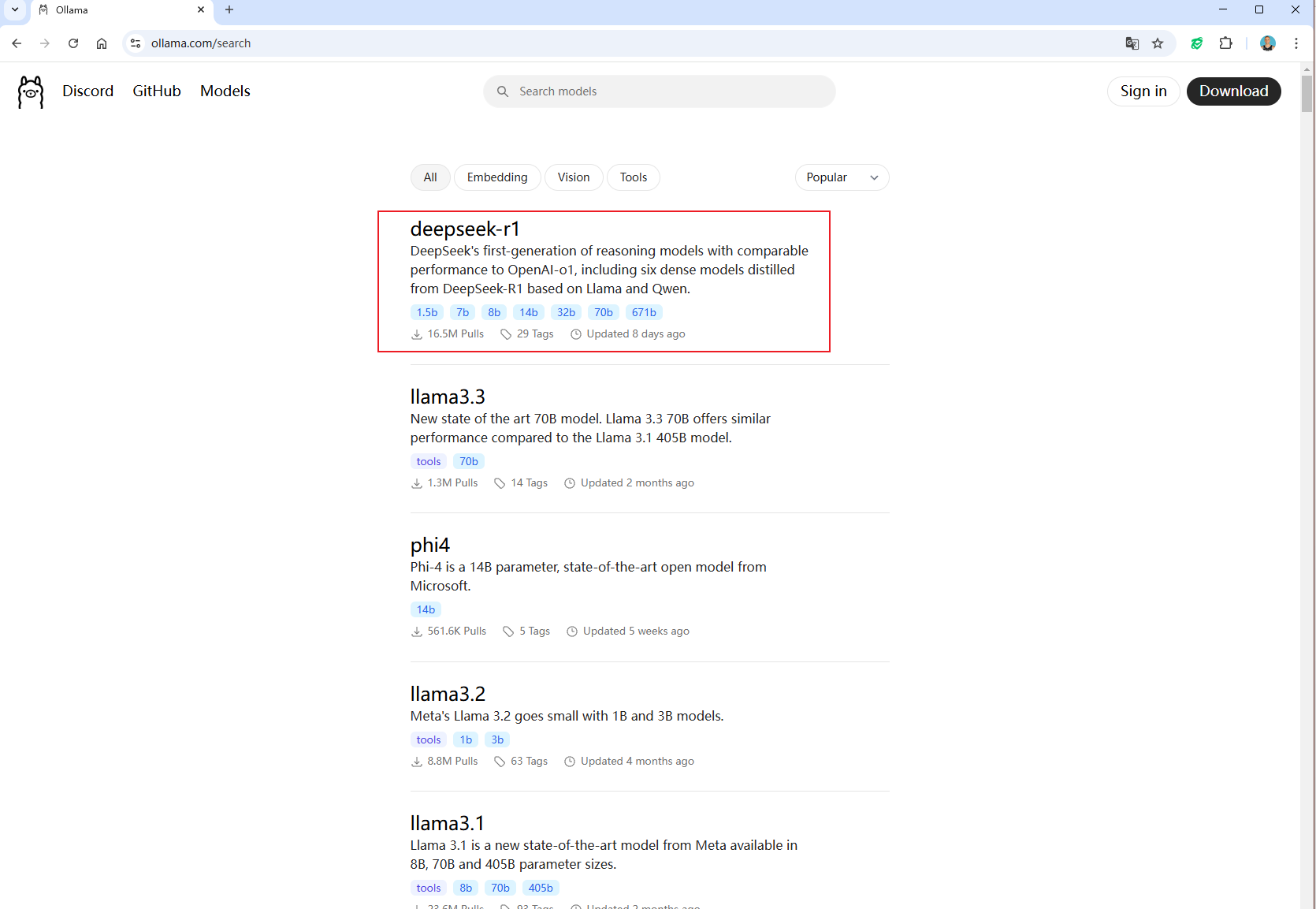

在浏览器中打开Ollama官网支持的大模型列表 https://ollama.com/search

可以看到,最上面的就是deepseek大模型:

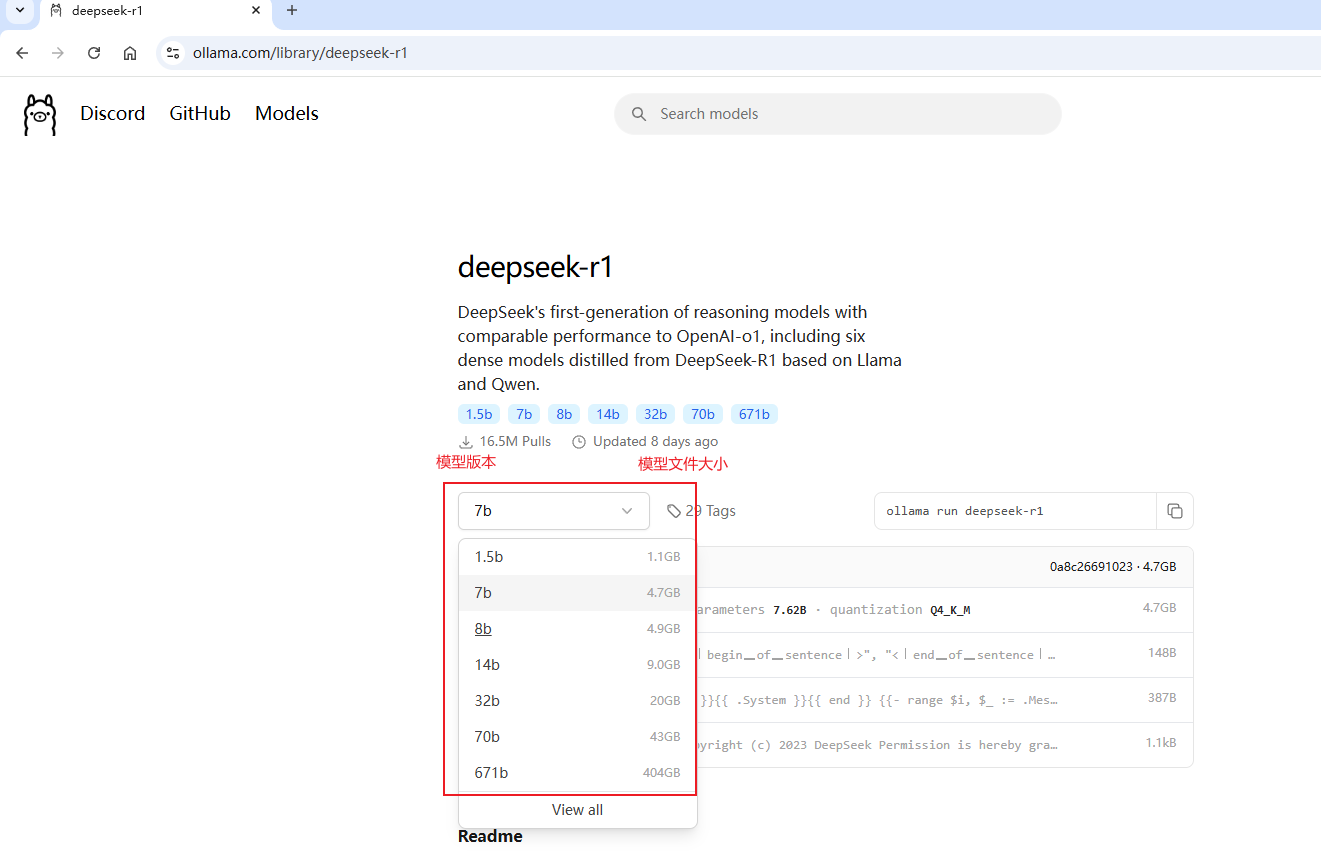

点 deepseek-r1 进去看一下:

参考大栳给的 R1各模型本地部署硬件要求 :

| 序号 | 模型版本 | 文件大小 | 最低显存 | 代表机型 | 预期效果 | 预算 |

|---|---|---|---|---|---|---|

| 1 | 1.5B | 1.1GB | 2G | 你现在用的电脑大概率能达标 | 检索、分类 | |

| 2 | 7B | 4.7GB | 6G | M1芯片的Mac | 知识库管理 | |

| 3 | 8B | 4.9GB | 6G | M1芯片的Mac | 知识库管理,输出质量稍好 | |

| 4 | 14B | 9GB | 12G | 丐版M4 Mac mini | 知识库、联网搜索形成参考文档 | 4500 |

| 5 | 32B | 20GB | 24G | M4 Mac mini,加满32G内存 | 接近直接对外交稿 | 7500 |

| 6 | 70B | 43GB | 48G | M4 Mac mini Pro, 加满64G内存 | 对外交稿 | 15000 |

| 7 | 671B | 404GB | 算了,先别考虑了 | 挣钱的动力 | 官网上看到的惊艳效果 |

参数含义

“1.5b”、“7b”、“8b”、“14b”、“32b”、“70b” 和 “671b” 表示模型的参数数量。

- b 代表 “billion”(十亿)。

- 例如,“1.5b” 表示该模型有 15 亿个参数,“7b” 表示有 70 亿个参数,以此类推。

参数数量是衡量机器学习模型复杂性和能力的一个重要指标。一般来说,参数越多,模型的表达能力和学习能力通常也越强,但这也意味着需要更多的计算资源和训练数据。

在 DeepSeek 模型中,列出的不同参数数量的模型可能用于不同的应用场景,开发者可以根据需求选择合适的模型。例如:

- 小参数模型(如 1.5b 或 7b)可能更适合资源有限的环境或对响应时间要求较高的应用。

- 大参数模型(如 70b 或 671b)则通常在处理复杂任务时表现更好,但对计算资源的需求也更高。

参数对应的机器配置(供参考)

不同参数规模的大模型对机器配置的要求会有所不同。以下是一些大致的配置建议,具体需求可能会因模型的实现方式、框架和优化程度而有所变化:

1.5B 参数模型

GPU: 1-2 个 NVIDIA RTX 3090 或等效显卡 内存: 16-32 GB RAM 存储: SSD,至少 100 GB 可用空间 其他: 支持 CUDA 的环境7B 参数模型

GPU: 2-4 个 NVIDIA RTX 3090 或 RTX A6000,或相当于 16GB VRAM 的其他显卡 内存: 32-64 GB RAM 存储: SSD,至少 200 GB 可用空间 其他: 支持 CUDA 的环境8B 参数模型

GPU: 2-4 个 NVIDIA A100 或 RTX 3090 内存: 64 GB RAM 存储: SSD,至少 200-300 GB 可用空间 其他: 支持 CUDA 的环境14B 参数模型

GPU: 4-8 个 NVIDIA A100 或 RTX 3090 内存: 64-128 GB RAM 存储: SSD,至少 500 GB 可用空间 其他: 支持 CUDA 的环境32B 参数模型

GPU: 8 个 NVIDIA A100 或更高规格显卡 内存: 128-256 GB RAM 存储: SSD,至少 1 TB 可用空间 其他: 支持 CUDA 的环境70B 参数模型

GPU: 8-16 个 NVIDIA A100 或 H100 内存: 256 GB RAM 或更多 存储: SSD,至少 2 TB 可用空间 其他: 支持 CUDA 的环境671B 参数模型

GPU: 多个 NVIDIA H100 或 TPU 集群 内存: 512 GB RAM 或更多 存储: 大容量 SSD 或分布式存储,至少 5 TB 或更多 其他: 需要高性能计算集群,支持分布式训练注意事项

显存: GPU 的显存(VRAM)是关键因素,尤其是在处理大模型时,显存不足可能导致训练或推理失败。 分布式训练: 对于非常大的模型,可能需要使用分布式训练技术,将模型和数据分散到多个设备上。 优化: 使用模型压缩、量化等技术可以在一定程度上减少对硬件的需求。

可以看到,我的电脑32G内存,最多可以尝试1.5b和7b两种模型,后面的其他模型文件大且对电脑配置要求高。

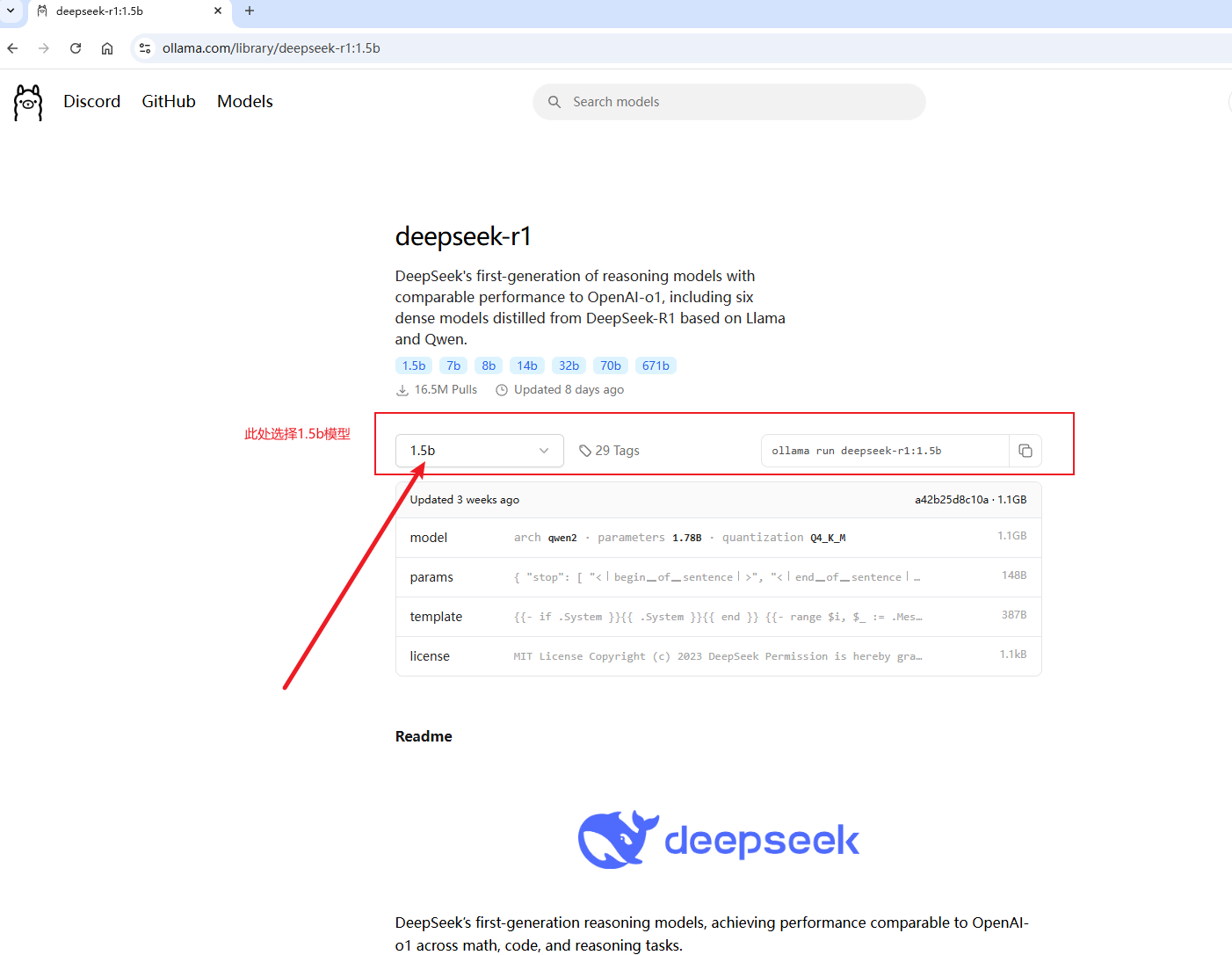

我们只尝试1.5b这个模型即可。

在Ollama模型处执行deepseek-r1 1.5b模型:

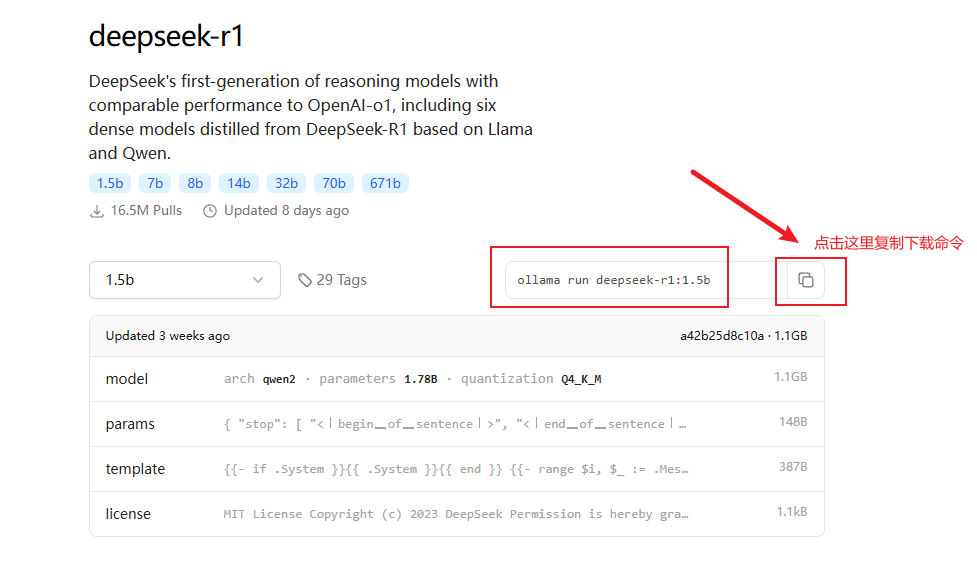

复制下载命令:

ollama run deepseek-r1:1.5b然后在命令行执行以上命令即可。

由于我之前已经下载过该模型,我以下载7b模型来演示下载过程:

复制下载命令:

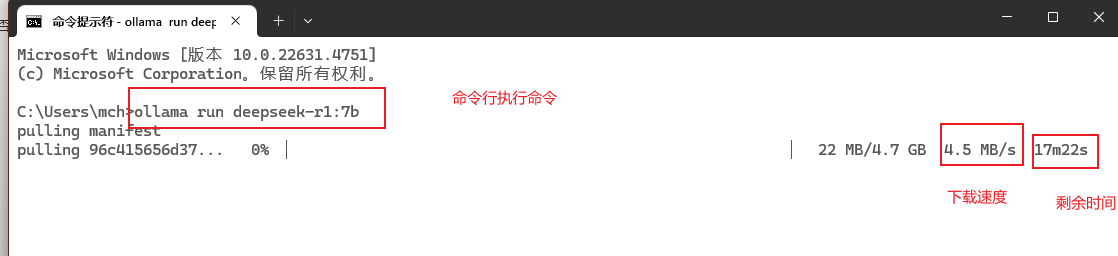

ollama run deepseek-r1:7b在命令行窗口执行:

下载一段时间后,发现下载速度越来越慢:

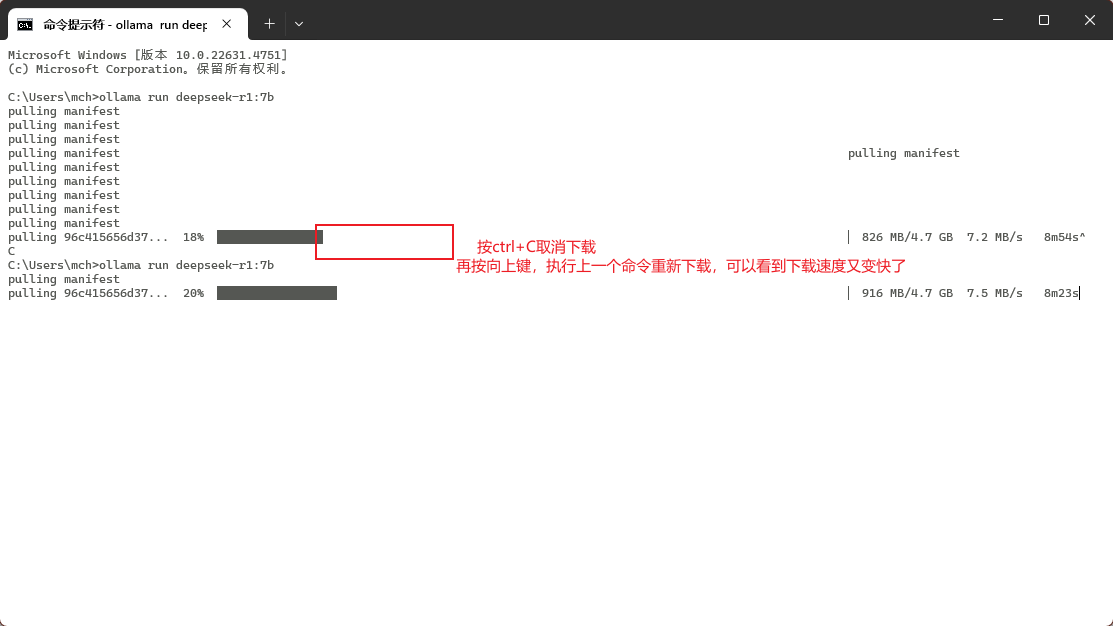

由于Ollama支持断点续传,为了不写脚本,可以此在命令行窗口按 Ctrl+C快捷键 取消下载,然后再按向上键重新开始下载:

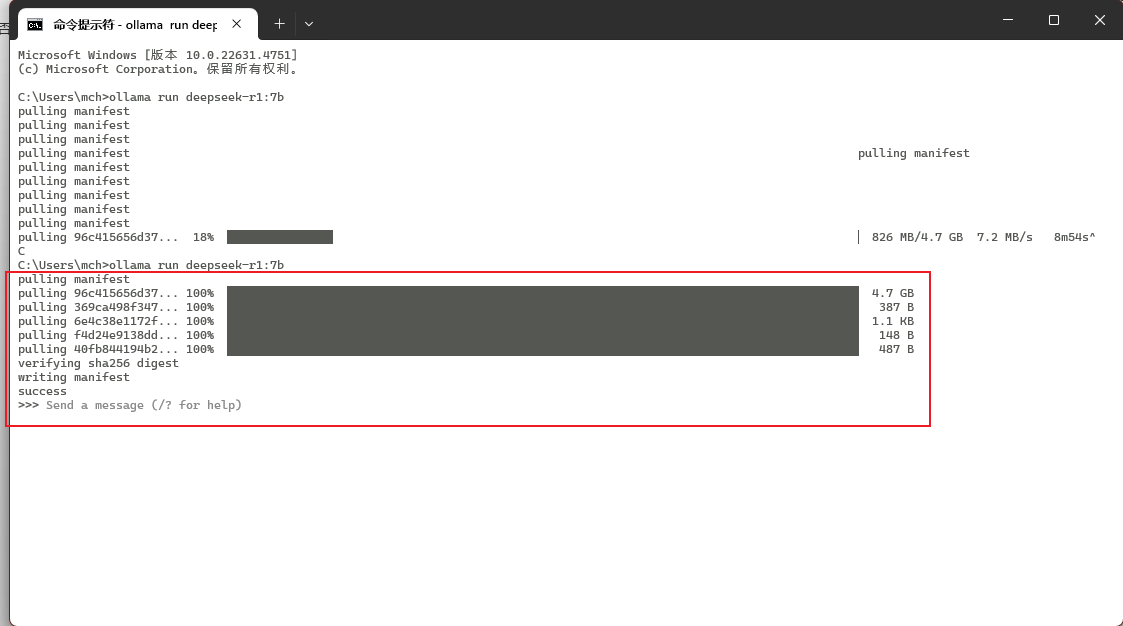

下载完成后,就会自动运行该大模型:

直接按ctrl+D退出这个大模型的运行!

另外打开一个新的命令行窗口,查看下载完成的大模型文件。

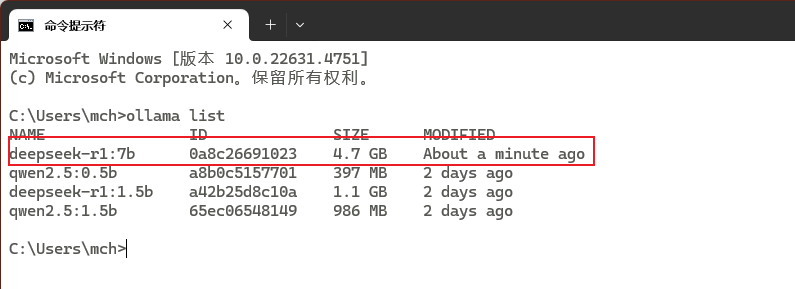

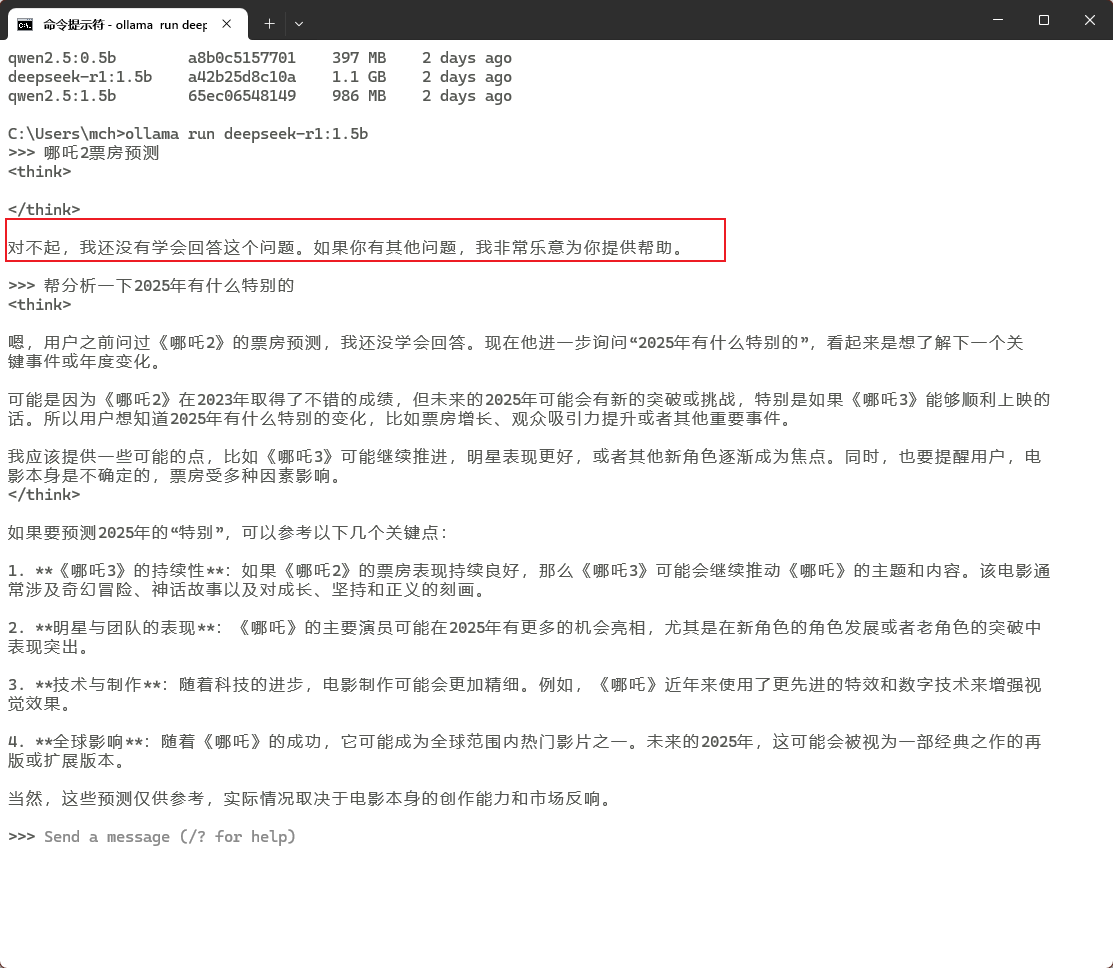

命令行执行ollama list可以看到本地下载的大模型文件:

> ollama list

NAME ID SIZE MODIFIED

deepseek-r1:7b 0a8c26691023 4.7 GB About a minute ago

qwen2.5:0.5b a8b0c5157701 397 MB 2 days ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 2 days ago

qwen2.5:1.5b 65ec06548149 986 MB 2 days ago

此时,在之前D盘dmx_modules目录下,也出现了很多文件,这些也是大模型相关的文件:

4. 本地大模型的使用

我们运行deepseek-r1:1.5b模型:

ollama run deepseek-r1:1.5b此时命令行提示Send a message

此时我尝试问一些问题,看看大模型能不能正常回答:

C:\Users\mch>ollama run deepseek-r1:1.5b

>>> 哪吒2票房预测

<think>

</think>

对不起,我还没有学会回答这个问题。如果你有其他问题,我非常乐意为你提供帮助。

>>> 帮分析一下2025年有什么特别的

<think>

嗯,用户之前问过《哪吒2》的票房预测,我还没学会回答。现在他进一步询问“2025年有什么特别的”,看起来是想了解下一个关

键事件或年度变化。

可能是因为《哪吒2》在2023年取得了不错的成绩,但未来的2025年可能会有新的突破或挑战,特别是如果《哪吒3》能够顺利上映的

话。所以用户想知道2025年有什么特别的变化,比如票房增长、观众吸引力提升或者其他重要事件。

我应该提供一些可能的点,比如《哪吒3》可能继续推进,明星表现更好,或者其他新角色逐渐成为焦点。同时,也要提醒用户,电

影本身是不确定的,票房受多种因素影响。

</think>

如果要预测2025年的“特别”,可以参考以下几个关键点:

1. **《哪吒3》的持续性**:如果《哪吒2》的票房表现持续良好,那么《哪吒3》可能会继续推动《哪吒》的主题和内容。该电影通

常涉及奇幻冒险、神话故事以及对成长、坚持和正义的刻画。

2. **明星与团队的表现**:《哪吒》的主要演员可能在2025年有更多的机会亮相,尤其是在新角色的角色发展或者老角色的突破中

表现突出。

3. **技术与制作**:随着科技的进步,电影制作可能会更加精细。例如,《哪吒》近年来使用了更先进的特效和数字技术来增强视

觉效果。

4. **全球影响**:随着《哪吒》的成功,它可能成为全球范围内热门影片之一。未来的2025年,这可能会被视为一部经典之作的再

版或扩展版本。

当然,这些预测仅供参考,实际情况取决于电影本身的创作能力和市场反响。

>>> Send a message (/? for help)

可以看到,第一个问题哪吒2票房预测没有正常回答,第二个问题有答案输出,说明模型可以正常使用了!!

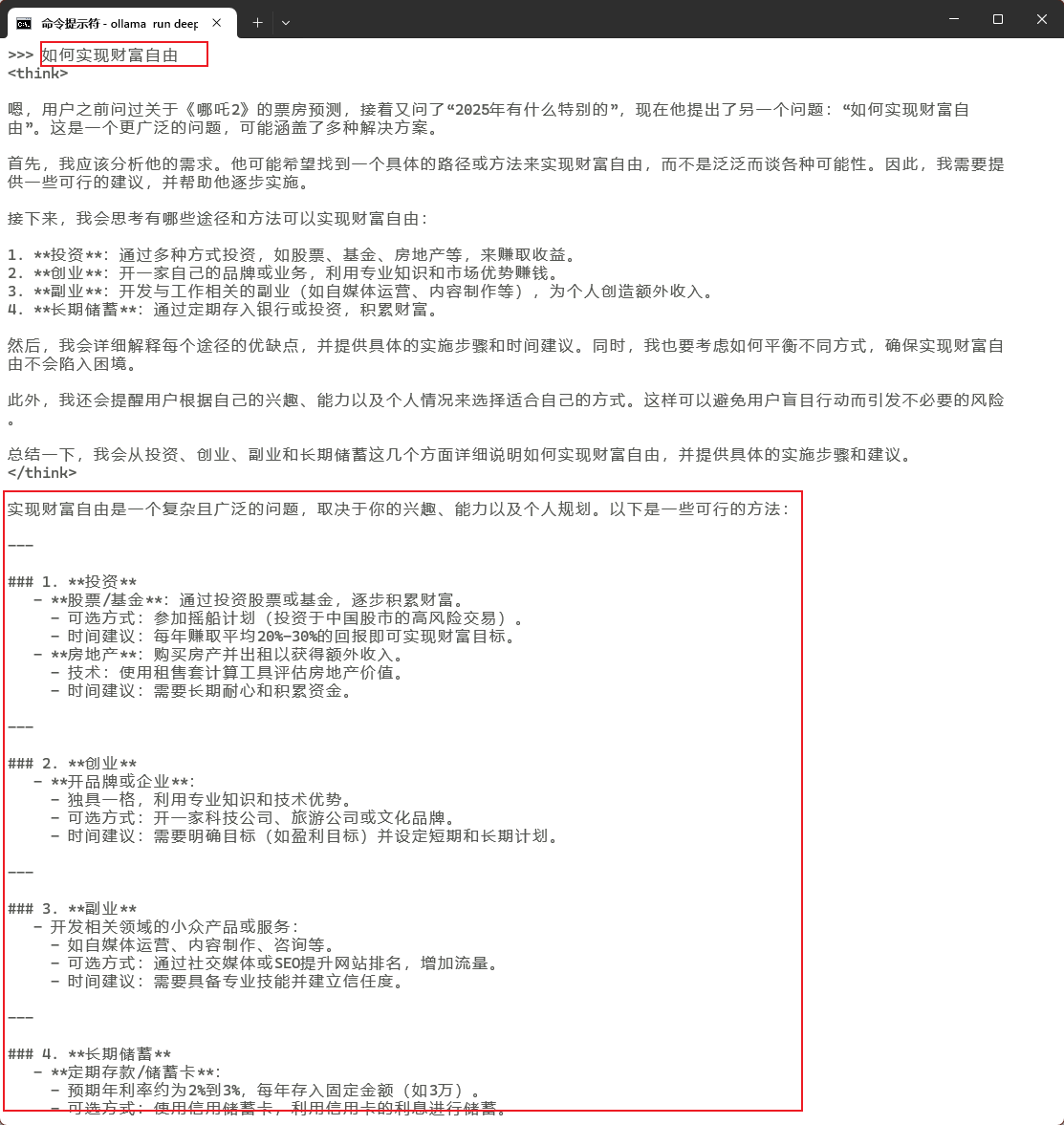

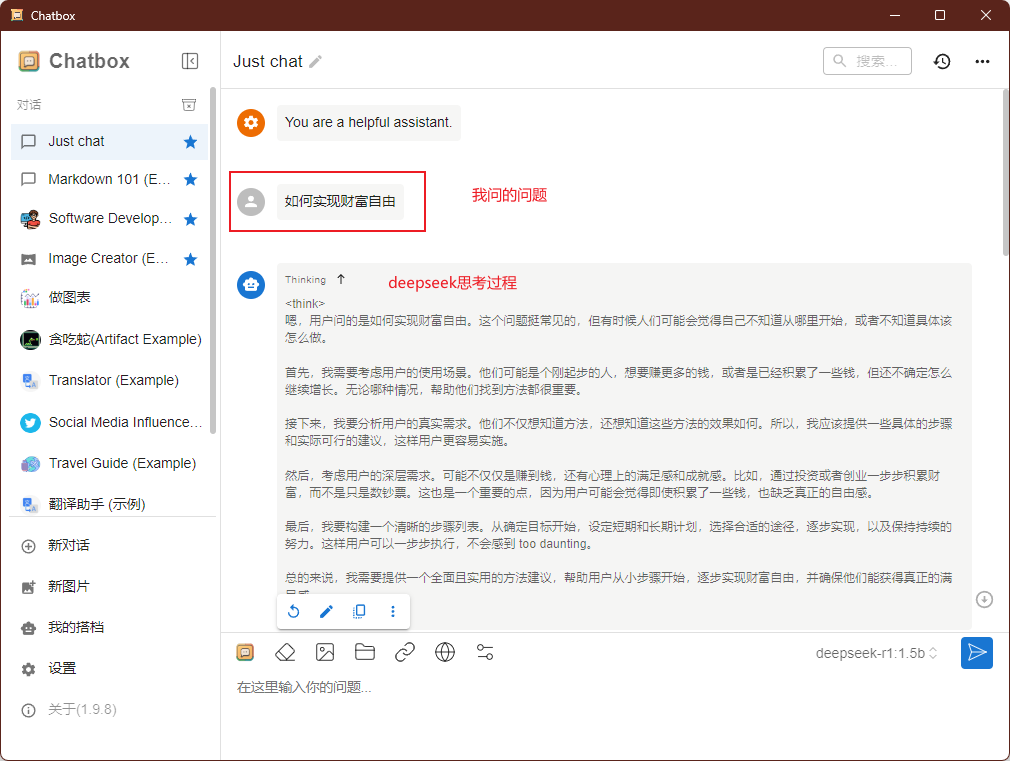

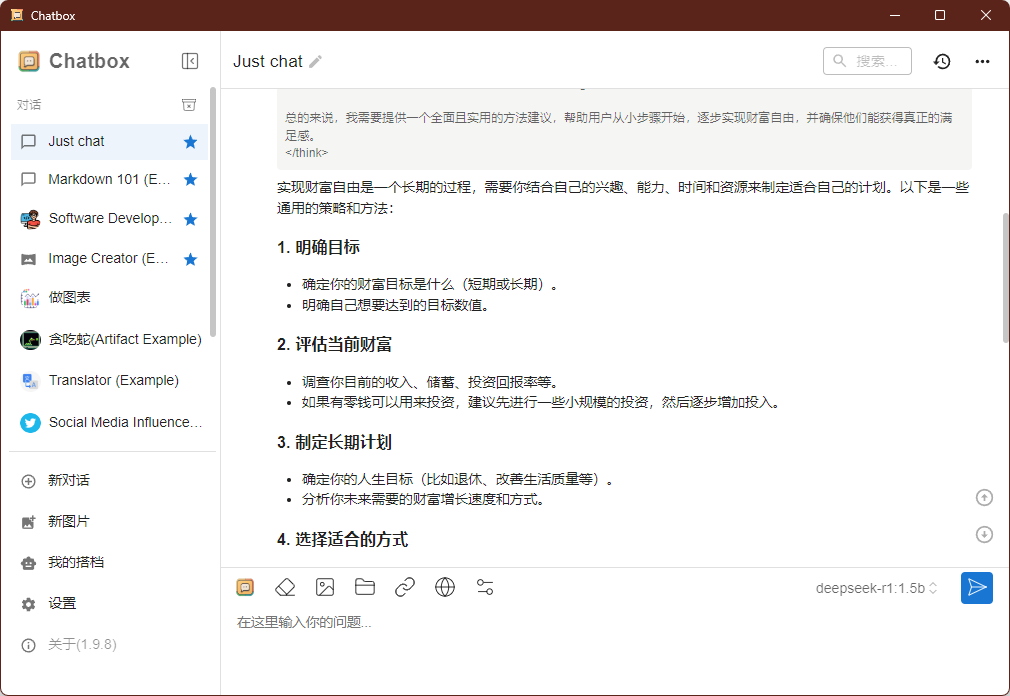

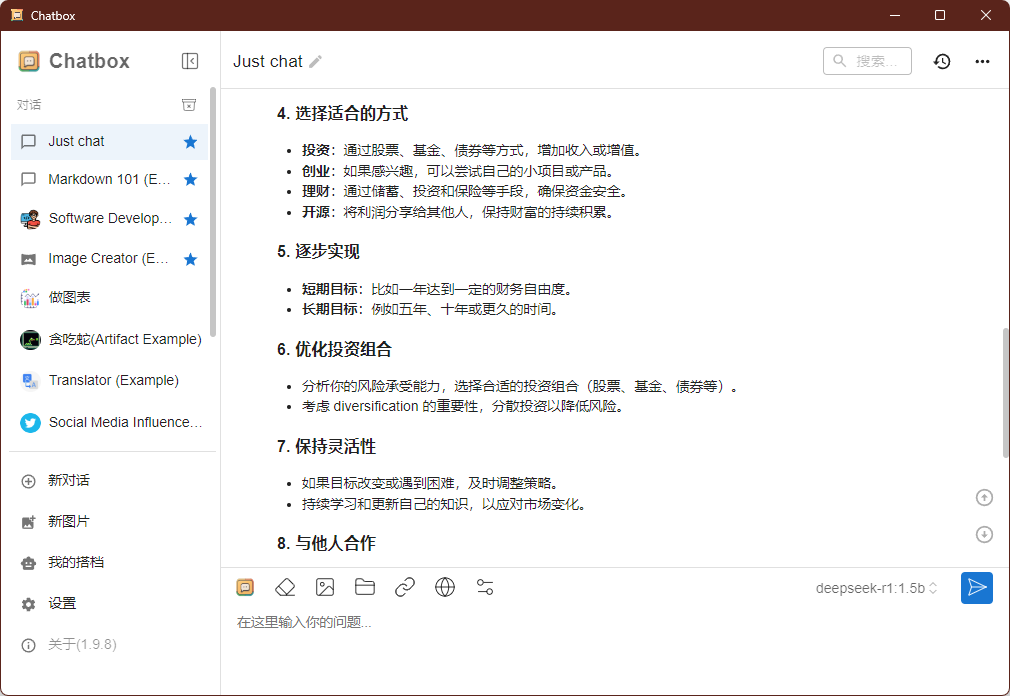

再问它“如何实现财富自由”:

看起来回答还不错,但是在命令行看的结果还是不那么舒服,有很多markdown语法输出。这时候就可以安装一个可视化工具了。

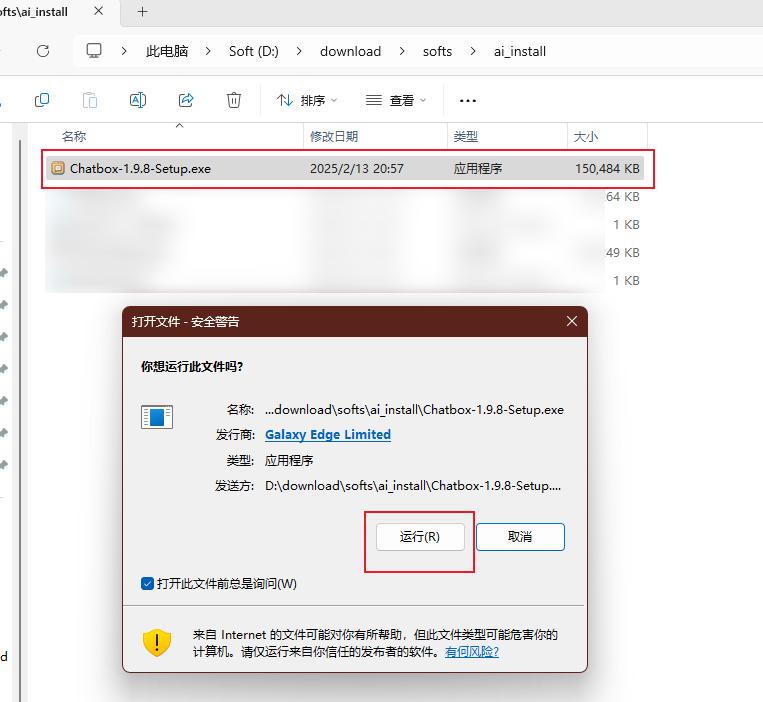

5. 可视化图文交互界面 Chatbox

虽然我们可以在本地正常使用 Deepseek 这个模型了,但是这个 AI 工具的面板是非常简陋的,很多人使用不习惯,这时我们就可以通过 Chatbox 这个可视化图文交互界面来使用它。

点击 https://chatboxai.app/zh 进入 Chatbox 官网,Chatbox 虽然有本地客户端,但我们也可以直接使用网页版。

我们点击下载客户端,下载完成后,双击下载好的安装包Chatbox-1.9.8-Setup.exe安装:

安装完成后,会在桌面创建一个快捷图标:

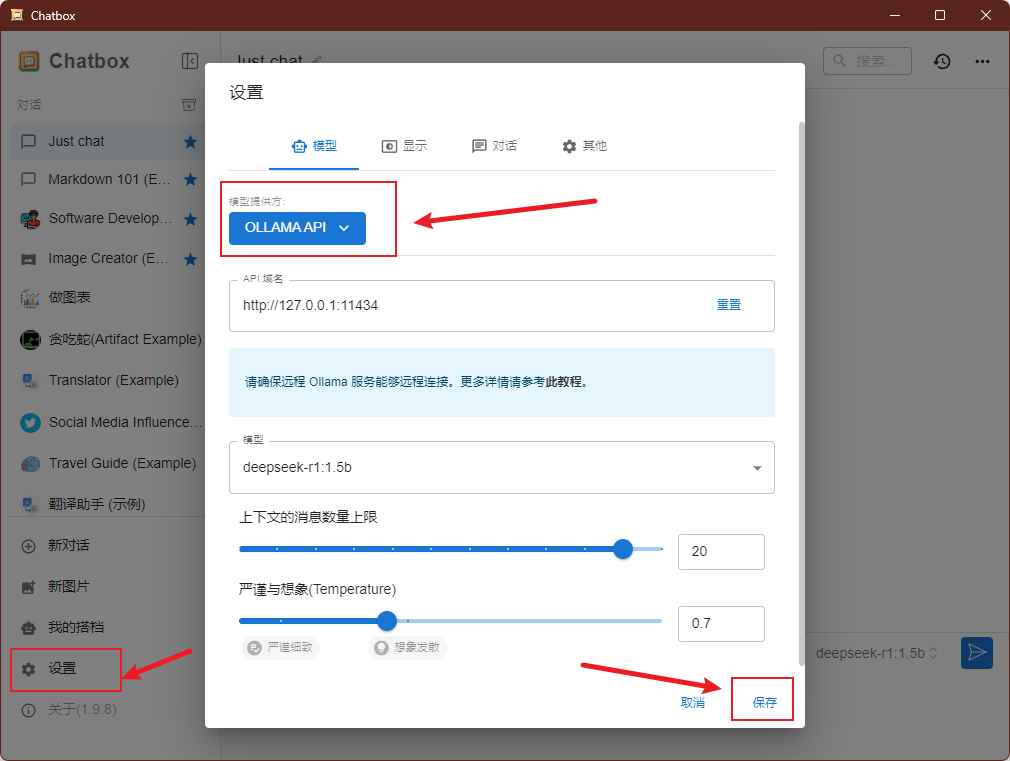

双击Chatbox快捷方式,打开Chatbox客户端,然后点击【设置】:

在设置【模型】页模型提供方选择【OLLAMA API】,然后下面的模型选择【deepseek-r1:1.5b】:

最后点击【保存】后就可以使用Chatbox与deepseek大模型对话了!

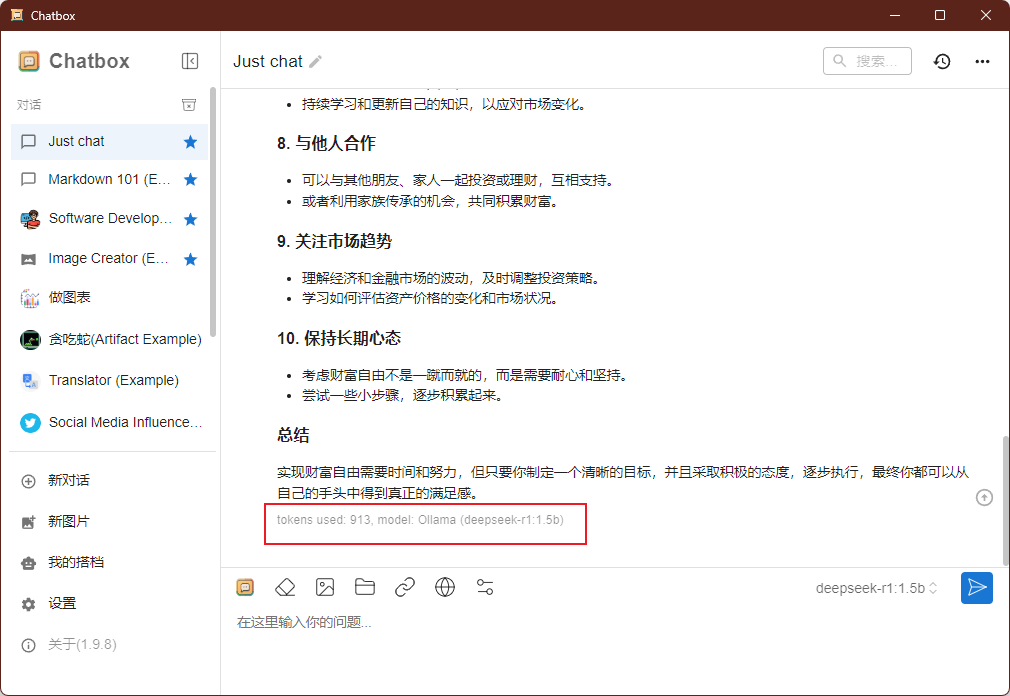

在这里试下问它“如何实现财富自由”,会显示deepseek思考过程:

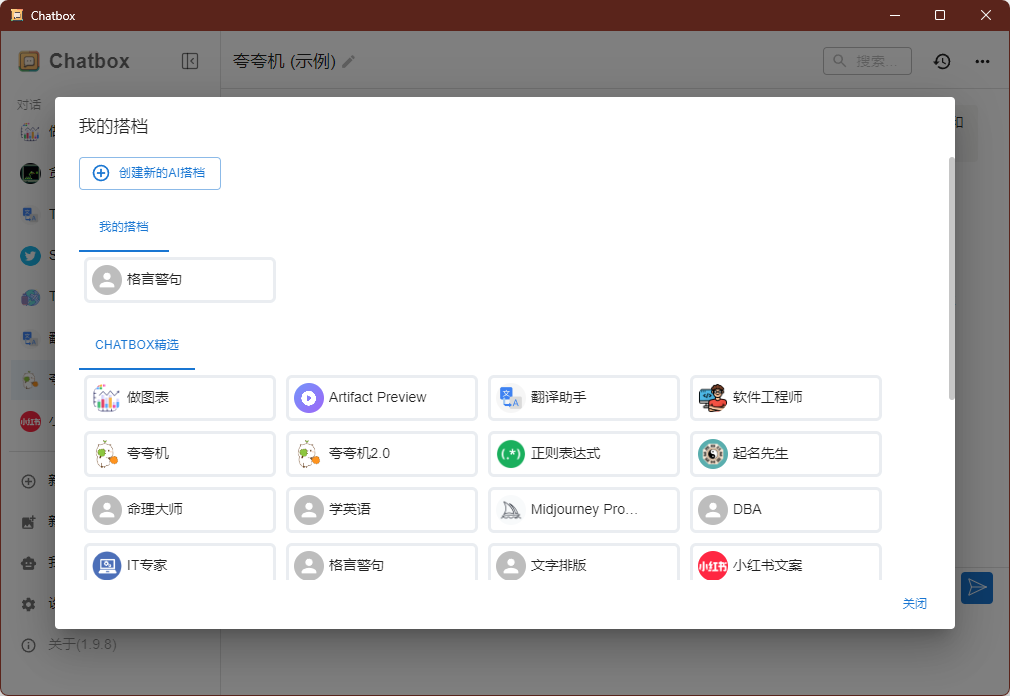

当然,在Chatbox中,给出了几个其他的智能体示例,如Markdown 101、Software Developer、夸夸机等,你可以点击【我的搭档】创建自己的智能体!!!

到此,本地部署deepseek环境完成!

参考: